Iklan

Jika kamu menjalankan situs web 10 Cara Membuat Website Kecil Dan Sederhana Tanpa BerlebihanWordPress bisa menjadi berlebihan. Seperti yang dibuktikan oleh layanan luar biasa lainnya ini, WordPress bukanlah segalanya dan mengakhiri semua pembuatan situs web. Jika Anda menginginkan solusi yang lebih sederhana, ada berbagai pilihan. Baca selengkapnya , Anda mungkin pernah mendengar tentang file robots.txt (atau “standar pengecualian robot”). Apakah Anda memilikinya atau tidak, inilah saatnya untuk mempelajarinya, karena file teks sederhana ini adalah bagian penting dari situs Anda. Ini mungkin tampak tidak penting, tetapi Anda mungkin terkejut betapa pentingnya hal itu.

Mari kita lihat apa itu file robots.txt, apa fungsinya, dan cara mengaturnya dengan benar untuk situs Anda.

Apa itu File robots.txt?

Untuk memahami cara kerja file robots.txt, Anda perlu mengetahui sedikit tentang mesin pencari Bagaimana Mesin Pencari Bekerja?Bagi banyak orang, Google ADALAH internet. Ini bisa dibilang penemuan paling penting sejak Internet itu sendiri. Dan meskipun mesin pencari telah banyak berubah sejak saat itu, prinsip dasarnya masih sama. Baca selengkapnya . Versi singkatnya adalah mereka mengirimkan "crawler", yaitu program yang menjelajahi internet untuk mencari informasi. Mereka kemudian menyimpan beberapa informasi itu sehingga mereka dapat mengarahkan orang ke sana nanti.

Perayap ini, juga dikenal sebagai "bot" atau "laba-laba", menemukan halaman dari miliaran situs web. Mesin pencari memberi mereka petunjuk ke mana harus pergi, tetapi situs web individu juga dapat berkomunikasi dengan bot dan memberi tahu mereka halaman mana yang harus mereka lihat.

Sebagian besar waktu, mereka sebenarnya melakukan yang sebaliknya, dan memberi tahu mereka halaman mana yang mereka seharusnya tidak akan melihat. Hal-hal seperti halaman administratif, portal backend, halaman kategori dan tag, dan hal-hal lain yang tidak ingin ditampilkan oleh pemilik situs di mesin telusur. Halaman ini masih dapat dilihat oleh pengguna, dan dapat diakses oleh siapa saja yang memiliki izin (biasanya semua orang).

Tetapi dengan memberi tahu laba-laba itu untuk tidak mengindeks beberapa halaman, file robots.txt membantu semua orang. Jika Anda mencari "MakeUseOf" di mesin pencari, apakah Anda ingin halaman administratif kami muncul di peringkat atas? Tidak. Itu tidak ada gunanya bagi siapa pun, jadi kami memberi tahu mesin telusur untuk tidak menampilkannya. Ini juga dapat digunakan untuk mencegah mesin pencari memeriksa halaman yang mungkin tidak membantu mereka mengklasifikasikan situs Anda dalam hasil pencarian.

Singkatnya, robots.txt memberi tahu perayap web apa yang harus dilakukan.

Bisakah Crawler Mengabaikan robots.txt?

Apakah perayap pernah mengabaikan file robots.txt? Ya. Faktanya, banyak crawler melakukan abaikan itu. Namun, secara umum, perayap tersebut bukan dari mesin telusur yang memiliki reputasi baik. Mereka berasal dari spammer, pemanen email, dan jenis bot otomatis lainnya Cara Membangun Perayap Web Dasar untuk Menarik Informasi Dari Situs WebPernah ingin menangkap informasi dari sebuah situs web? Berikut ini cara menulis perayap untuk menavigasi situs web dan mengekstrak apa yang Anda butuhkan. Baca selengkapnya yang berkeliaran di internet. Penting untuk mengingat hal ini — menggunakan standar pengecualian robot untuk memberi tahu bot agar tidak masuk bukanlah tindakan keamanan yang efektif. Faktanya, beberapa bot mungkin Mulailah dengan halaman yang Anda beri tahu mereka untuk tidak pergi.

Mesin pencari, bagaimanapun, akan melakukan apa yang dikatakan file robots.txt Anda selama itu diformat dengan benar.

Cara Menulis File robots.txt

Ada beberapa bagian berbeda yang masuk ke file standar pengecualian robot. Saya akan memecahnya satu per satu di sini.

Deklarasi Agen Pengguna

Sebelum Anda memberi tahu bot halaman mana yang tidak boleh dilihat, Anda harus menentukan bot mana yang Anda ajak bicara. Sebagian besar waktu, Anda akan menggunakan deklarasi sederhana yang berarti "semua bot." Itu terlihat seperti ini:

Agen pengguna: *Tanda bintang berarti "semua bot." Namun, Anda dapat menentukan halaman untuk bot tertentu. Untuk melakukan itu, Anda harus mengetahui nama bot yang menjadi pedoman Anda. Itu mungkin terlihat seperti ini:

Agen-pengguna: Googlebot. [daftar halaman yang tidak boleh dirayapi] Agen-pengguna: Googlebot-Image/1.0. [daftar halaman yang tidak boleh dirayapi] Agen pengguna: Bingbot. [daftar halaman yang tidak boleh dirayapi]Dan seterusnya. Jika Anda menemukan bot yang sama sekali tidak Anda inginkan untuk merayapi situs Anda, Anda juga dapat menentukannya.

Untuk menemukan nama agen pengguna, lihat useragentstring.com [Tidak Lagi Tersedia].

Larang Halaman

Ini adalah bagian utama dari file pengecualian robot Anda. Dengan deklarasi sederhana, Anda memberi tahu bot atau grup bot untuk tidak merayapi halaman tertentu. Sintaksnya mudah. Inilah cara Anda melarang akses ke semua yang ada di direktori "admin" situs Anda:

Larang: /admin/Baris itu akan mencegah bot merayapi situs Anda.com/admin, situsAnda.com/admin/login, situsAnda.com/admin/files/secret.html, dan apa pun yang berada di bawah direktori admin.

Untuk melarang satu halaman, cukup tentukan di baris larangan:

Larang: /public/exception.htmlSekarang halaman "pengecualian" tidak akan ditarik, tetapi semua yang lain di folder "publik" akan.

Untuk menyertakan beberapa direktori atau halaman, cukup cantumkan di baris berikutnya:

Larang: /pribadi/ Larang: /admin/ Larang: /cgi-bin/ Larang: /temp/Keempat baris tersebut akan berlaku untuk agen pengguna mana pun yang Anda tentukan di bagian atas.

Jika Anda ingin agar bot tidak melihat halaman mana pun di situs Anda, gunakan ini:

Larang: /Menetapkan Standar Berbeda untuk Bot

Seperti yang kita lihat di atas, Anda dapat menentukan halaman tertentu untuk bot yang berbeda. Menggabungkan dua elemen sebelumnya, inilah tampilannya:

Agen-pengguna: googlebot. Larang: /admin/ Larang: /private/ Agen pengguna: bingbot. Larang: /admin/ Larang: /pribadi/ Larang: /rahasia/Bagian "admin" dan "pribadi" tidak akan terlihat di Google dan Bing, tetapi Google akan melihat direktori "rahasia", sementara Bing tidak.

Anda dapat menentukan aturan umum untuk semua bot dengan menggunakan agen pengguna asterisk, dan kemudian memberikan instruksi khusus untuk bot di bagian berikutnya juga.

Menyatukan Semuanya

Dengan pengetahuan di atas, Anda dapat menulis file robots.txt secara lengkap. Jalankan saja editor teks favorit Anda (kami penggemar Sublim 11 Tip Teks Sublim untuk Produktivitas dan Alur Kerja yang Lebih CepatSublime Text adalah editor teks serbaguna dan standar emas bagi banyak programmer. Kiat kami berfokus pada pengkodean yang efisien, tetapi pengguna umum akan menghargai pintasan keyboard. Baca selengkapnya di sekitar sini) dan mulailah memberi tahu bot bahwa mereka tidak diterima di bagian tertentu situs Anda.

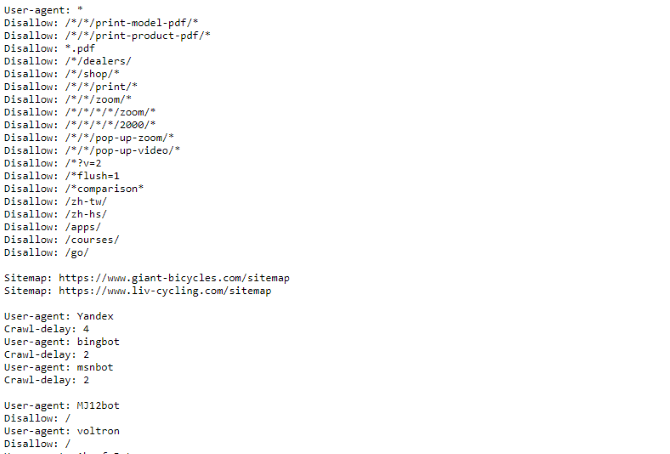

Jika Anda ingin melihat contoh file robots.txt, cukup buka situs mana pun dan tambahkan “/ robots.txt” di bagian akhir. Berikut bagian dari file robots.txt Sepeda Raksasa:

Seperti yang Anda lihat, ada beberapa halaman yang tidak ingin mereka tampilkan di mesin pencari. Mereka juga menyertakan beberapa hal yang belum kita bicarakan. Mari kita lihat apa lagi yang dapat Anda lakukan di file pengecualian robot Anda.

Menemukan Peta Situs Anda

Jika file robots.txt Anda memberi tahu bot di mana bukan untuk pergi, kamu peta situs melakukan yang sebaliknya Cara Membuat Peta Situs XML Dalam 4 Langkah MudahAda dua jenis peta situs - halaman HTML atau file XML. Peta situs HTML adalah satu halaman yang menunjukkan kepada pengunjung semua halaman di situs web dan biasanya memiliki tautan ke... Baca selengkapnya , dan membantu mereka menemukan apa yang mereka cari. Dan sementara mesin pencari mungkin sudah tahu di mana peta situs Anda, tidak ada salahnya untuk memberi tahu mereka lagi.

Deklarasi untuk lokasi peta situs sederhana:

Peta Situs: [URL peta situs]Itu dia.

Dalam file robots.txt kita sendiri, terlihat seperti ini:

Peta Situs: //www.makeuseof.com/sitemap_index.xmlItu saja.

Mengatur Penundaan Perayapan

Arahan penundaan perayapan memberi tahu mesin telusur tertentu seberapa sering mereka dapat mengindeks halaman di situs Anda. Ini diukur dalam hitungan detik, meskipun beberapa mesin pencari menafsirkannya sedikit berbeda. Beberapa melihat penundaan perayapan 5 sebagai menyuruh mereka menunggu lima detik setelah setiap perayapan untuk memulai perayapan berikutnya. Yang lain menafsirkannya sebagai instruksi untuk hanya merayapi satu halaman setiap lima detik.

Mengapa Anda memberi tahu perayap untuk tidak merayapi sebanyak mungkin? Ke menghemat bandwidth 4 Cara Windows 10 Membuang Bandwidth Internet AndaApakah Windows 10 membuang-buang bandwidth internet Anda? Inilah cara memeriksanya, dan apa yang dapat Anda lakukan untuk menghentikannya. Baca selengkapnya . Jika server Anda berjuang untuk mengikuti lalu lintas, Anda mungkin ingin melakukan penundaan perayapan. Secara umum, kebanyakan orang tidak perlu khawatir tentang hal ini. Namun, situs besar lalu lintas tinggi mungkin ingin bereksperimen sedikit.

Inilah cara Anda mengatur penundaan perayapan delapan detik:

Penundaan perayapan: 8Itu dia. Tidak semua mesin pencari akan mematuhi arahan Anda. Tapi tidak ada salahnya untuk bertanya. Seperti halnya halaman yang melarang, Anda dapat mengatur penundaan perayapan yang berbeda untuk mesin telusur tertentu.

Mengunggah File robots.txt Anda

Setelah Anda memiliki semua petunjuk di file Anda, Anda dapat mengunggahnya ke situs Anda. Pastikan itu adalah file teks biasa, dan memiliki nama robots.txt. Kemudian unggah ke situs Anda sehingga dapat ditemukan di situsAnda.com/robots.txt.

Jika Anda menggunakan sistem manajemen konten 10 Sistem Manajemen Konten Online Paling PopulerHari-hari halaman HTML kode tangan, dan menguasai CSS, sudah lama berlalu. Instal sistem manajemen konten (CMS) dan dalam beberapa menit Anda dapat memiliki situs web untuk dibagikan kepada dunia. Baca selengkapnya seperti WordPress, mungkin ada cara khusus yang Anda perlukan untuk melakukannya. Karena berbeda di setiap sistem manajemen konten, Anda harus berkonsultasi dengan dokumentasi untuk sistem Anda.

Beberapa sistem mungkin juga memiliki antarmuka online untuk mengunggah file Anda. Untuk ini, cukup salin dan tempel file yang Anda buat di langkah sebelumnya.

Ingatlah untuk Perbarui File Anda

Saran terakhir yang akan saya berikan adalah sesekali melihat file pengecualian robot Anda. Situs Anda berubah, dan Anda mungkin perlu melakukan beberapa penyesuaian. Jika Anda melihat perubahan aneh pada lalu lintas mesin telusur Anda, ada baiknya Anda juga memeriksa file tersebut. Mungkin juga notasi standar bisa berubah di masa depan. Seperti semua hal lain di situs Anda, ada baiknya memeriksanya sesekali.

Dari halaman mana Anda mengecualikan crawler di situs Anda? Pernahkah Anda memperhatikan perbedaan dalam lalu lintas mesin pencari? Bagikan saran dan komentar Anda di bawah ini!

Dann adalah konsultan strategi konten dan pemasaran yang membantu perusahaan menghasilkan permintaan dan prospek. Dia juga menulis blog tentang strategi dan pemasaran konten di dannalbright.com.